Robots.txt Nedir?

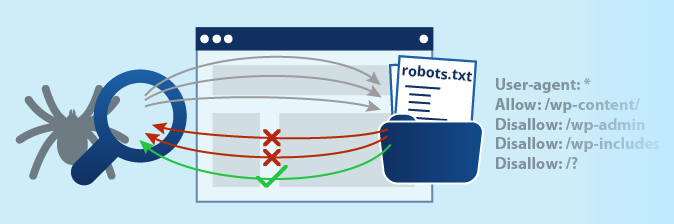

Robots.txt, örümcek dediğimiz arama motoru yazılımlarının sitemizde ilk ziyaret edeceği kök dizini dosyasıdır. Site sahibi bu dosyada dizine eklenmesini ve engellenmesini istediği dosyaları belirtir ve böylece arama motoru botlarına bir sınır koyar.

Bu dosyasının mutlaka her web sitesinde bulunması ve doğru komutlarla oluşturulması gereklidir. Yanlış komutlarla oluşturulmuş bir robots.txt dosyası web sitenizin hiçbir zaman dizine eklenmemesine dahi yol açabilir.

Robot.txt Dosyası Nasıl Oluşturulur?

Bu dosyayı oluşturmak gayet kolay bir işlemdir ancak daha önce de dediğimiz gibi dosya mutlaka ama mutlaka doğru oluşturulmalıdır.

- Öncelikle bilgisayar üzerinden herhangi bir metin düzenleyici ya da not defteri açıp adını robots.txt yapın. Sonrasında ise dosya içerisine gerekli komutları kaydedip sitenizin kök dizinine yükleyerek işlemi sonlandırın.

Ek olarak; dosyanın UTF-8 karakter kodlamasına uygun bir şekilde hazırlanmış olması ve site URL’siyle aynı formatta olması gereklidir.

- WordPress altyapılı bir siteniz varsa yukarıdaki işlemi yapabileceğiniz gibi robots.txt rewrite ve benzeri robots.txt eklentileri yardımı ile de dosyanızı oluşturabilirsiniz.

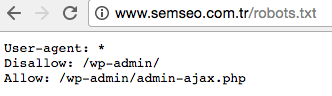

Dosyanızı kaydettikten sonra www.sitenizinadresi.uzantı.com/robots.txt şeklinde aratınca 404 almıyor ve böyle bir sayfa ile karşılaşıyorsanız ya da Google robots.txt test aracından izin verildi yanıtını alıyorsanız robots.txt dosyanızı oluşturma işleminiz tamamlanmış demektir.

Dosyanızı kaydettikten sonra www.sitenizinadresi.uzantı.com/robots.txt şeklinde aratınca 404 almıyor ve böyle bir sayfa ile karşılaşıyorsanız ya da Google robots.txt test aracından izin verildi yanıtını alıyorsanız robots.txt dosyanızı oluşturma işleminiz tamamlanmış demektir.

Robots.txt Komutları ve Anlamları

- User-agent: Bu komut sitenize hangi arama motoru botunun gelip hangisinin gelemeyeceğini belirtmenizi sağlar. Eğer yapım ve bakım aşamasında değilseniz sitenizi botlara kapatmamanızı öneririz. Eğer sitenizi arama motorlarının taramasını istemiyorsanız bu komutu dizin engelleme komutu olan disallow ile aşağıdaki gibi oluşturabilirsiniz.

user-agent: *

disallow: /

Tüm arama motorlarının botlarına izin vermek için ise, user-agent: * komutunu tek başına kullanmalısınız.

- Allow: Bu komut sitenizde hangi sayfaların dizine eklenmesini istediğinizi belirtmenizi sağlar.

user-agent: *

allow: /

Bu komutlar sitenizin tüm Google botlarına indexlenmek için açık olduğunu gösterir. Ancak admin bilgilerimizin gizli olması gerektiğinden bu komut pek de kullanılmaz.

- Disallow: Bu komut ise sitenizdeki hangi sayfaların dizine eklenmesini istemediğinizi belirtmenizi sağlar.

Örneğin:

user-agent: *

disallow: /seo/

Bu komutlar kullanıldığında www.sitenizinadresi.com/seo URL’indeki seo dizini ve buna bağlı hiç bir sayfa dizine eklenemez.

user-agent: *

disallow: /seo/site-ici-seo/

Bu komutlar kullanıldığında ise seo dizini ve buna bağlı URL’ler dizine eklenir ancak site içi seo dizine eklenemez.

- Crawl-delay: Sıklıkla sunucu hatası yaşayan ya da ziyaretçi trafiği yüksek olduğu için geçici süreli hizmet kesintisi olan sitelerin daha çok kullandığı bu komut botların site tarama süresini belirtmenizi sağlar.

Örneğin:

user-agent: * (burada özellikle bot türünü belirtebilirsiniz)

crawl-delay: 1

Bunların dışında site haritanızı da;

user-agent: *

Sitemap: www.sitenizinadresi.com/sitemap.xml

Komutu ile belirtebilirsiniz.

Tüm bunların dışında indexlenmesini istemediğiniz tekil sayfaları da metatag bölümünde

<meta name=”robots” content=”noindex” />

komutunu ekleyip o sayfanın indexlenmesini engelleyebilirsiniz.